Críticas a la utilización de Big Data.

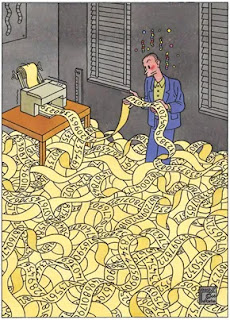

En un artículo publicado en el diario The New York Times se esbozó una critica al concepto de Big Data en 9 problemas:

Correlaciones:

En primer lugar, si bien la utilización de big data es una buena herramienta para detectar correlaciones, puede fallar al realizar correlaciones que tengan sentidos.

Un analisis por ejemplo podría revelar que del 2006 al 2011 en los Estados Unidos, la tasa de asesinato tuvo correlación con el valor de la acción de Internet Explorer: ambos cayeron considerablemente. Pero es dificil imaginar que exista una relación causal entre ambas situaciones.

Investigaciones científicas:

La Big Data puede funcionar bien como complemento de una investigación científica pero rara vez tiene éxito como reemplazo total de la misma ya que siempre se necesitará comenzar con un análisis que se base en una comprensión cabal de la física o de la bioquímica, según el caso.

Fácil manipulación:

Muchas herramientas basadas en Big Data pueden fácilmente ser manipuladas.

Por ejemplo, programas basados en Big Data para analizar ensayos realizados por estudiantes se basan en

medidas como el largo de una oración y el uso de palabras sofisticadas como correlación de notas más altas.

Esto claramente puede derivar en que los estudiantes, teniendo este conocimiento, usen estos tips para obtener mejores notas, en lugar de un texto coherente.

Poca solidez en resultados:

Google Flu Trend informó en 2009 que al analizar las consultas de búsquedas relacionadas con la gripe, había podido detectar la propagación de la gripe con mayor precisión que los Centros para el Control y la Prevención de Enfermedades.

Sin Embargo, unos años más tarde comenzó a fallar y se admitió que en los últimos años sus predicciones son más malas que buenas.

Efecto Echo - Chamber:

Esto se deriva del hecho de que gran parte de los grandes datos provienen de internet.

Cuando la fuente de información para Big Data es en sí misma producto de Big Data, se pueden presentar círculos viciosos.

Un ejemplo puede ser Google Translate que se basa en muchos pares de textos paralelos de distintos lenguajes para discernir los patrones de traducción entre dichos lenguajes.

Esto podría no presentar problemas, excepto por el hecho de que para algunos lenguajes poco frecuentes, muchos artículos de Wikipedia pueden haber sido realizados usando Google Translate. En dichos casos, errores del traductor pueden reflejarse en Wikipedia, volviendo a Translate reforzándolo.

Demasiadas Correlaciones:

Si buscamos 100 veces las correlaciones entre dos variables, podremos encontrar unas cinco correlaciones falsas que parecen estadísticamente significativas, aunque no haya una conexión real significativa entre ellas.

En ausencia de una supervisión cuidadosa, las magnitudes de los grandes datos pueden amplificar en gran medida estos errores.

Imprecisión:

El Big data es propenso a dar soluciones que suenan científicas a preguntas irremediablemente imprecisas. Puede reducir cualquier cosa a un solo número, pero no debe dejarse engañar por la apariencia de exactitud.

Nivel de Análisis:

Big Data es mejor cuando analiza cosas que son extremadamente comunes, pero a menudo se queda corto cuando analiza cosas que son menos comunes. Por ejemplo, los programas que usan big data para manejar texto, como los motores de búsqueda y los programas de traducción, a menudo dependen en gran medida de algo llamado trigramas: secuencias de tres palabras seguidas (como "en una fila"). Se puede recopilar información estadística confiable sobre trigramas comunes, precisamente porque aparecen con frecuencia. Pero ningún cuerpo de datos existente será lo suficientemente grande como para incluir todos los trigramas que la gente podría usar, debido a la continua inventiva del lenguaje.

Comentarios

Publicar un comentario